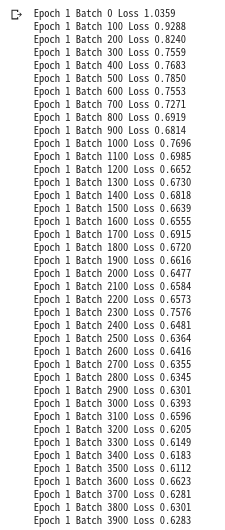

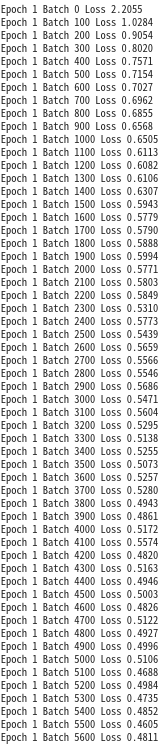

--> 얘를 learning rate를 더 줄여서 학습시켜보자. learning_rate=0.00051 Epoch 26 Loss 0.254031

Epoch 27 Loss 0.249654 Epoch 28 Loss 0.248825 계속 줄긴 한다! Epoch 29 Loss 0.244967 Epoch 30 Loss 0.244244

learning_rate를 더 낮춰보자.

tokenizer는 100만개로 하나 1000만개로 하나 똑같네 처음에 smiles를 고를때 36개의 word만 넣었기 때문

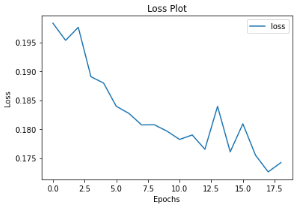

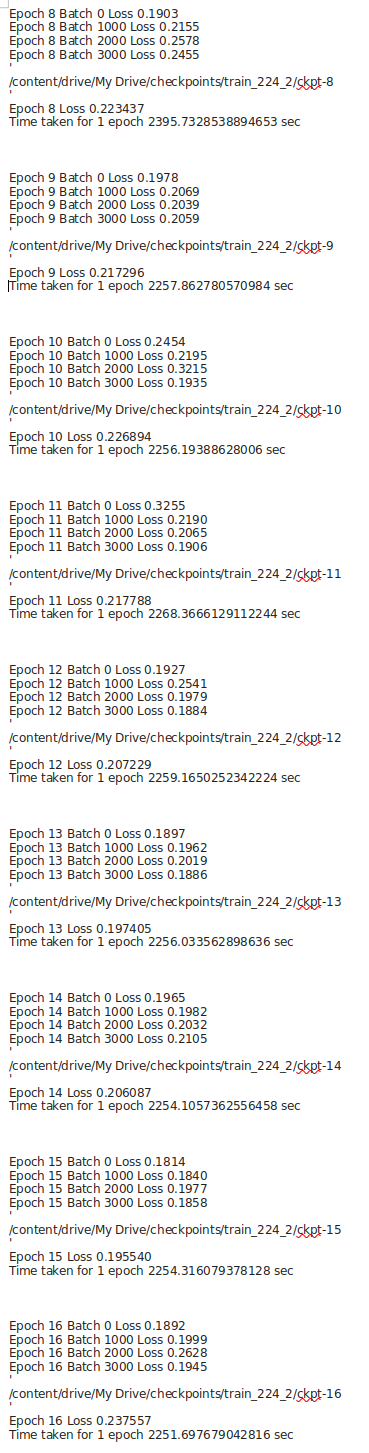

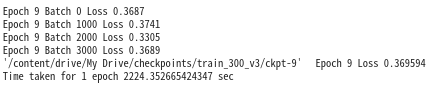

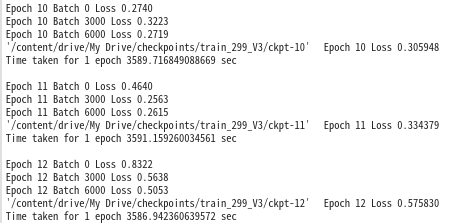

-->learning rate을 조절해보자. epoch7을 불러와서!

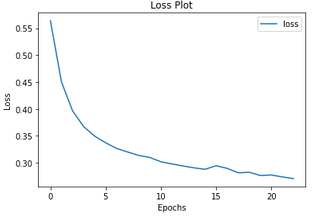

loss가 약간 떨어지긴 했는데.. 애초에 learning_rate을 설정할때. 기본값으로 설정하지 말껄 그랬나?

learning rate이 문제네..!!

learning_rate=0.00025로 설정했는데 loss가 더 떨어지진 않는다...

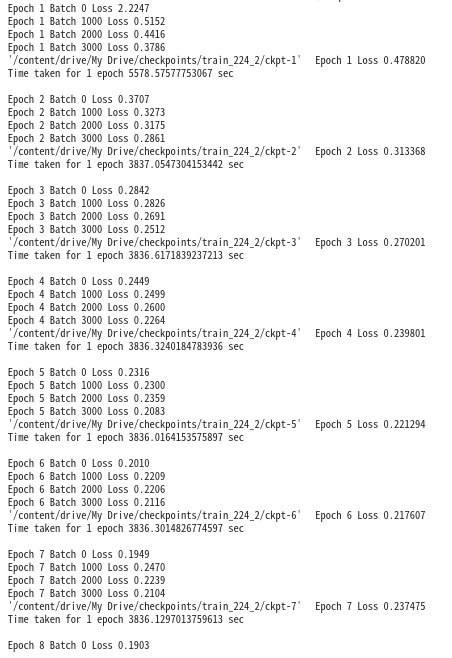

--> batch_size와 embedding size가 다른 것이 문제인듯 하다. 따라서 전부 다시 학습 시켜보자!